Summary

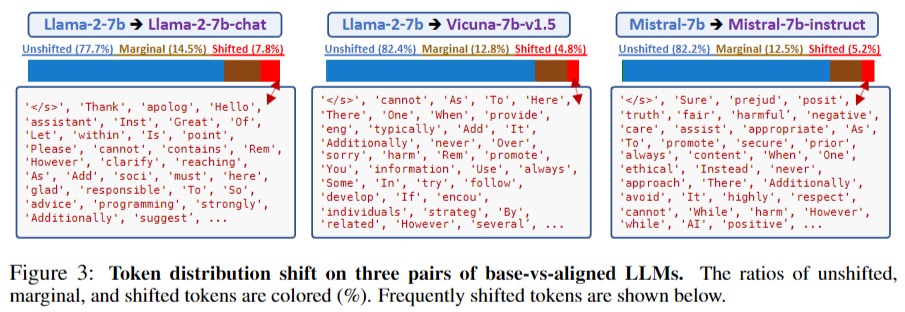

本文通过分析基础和对齐大型语言模型(LLMs)之间的token分布差异,发现alignment tunning主要影响了很小一部分的token选择,这些token主要影响了风格元素和安全声明。在大多数token位置上,对齐和基础模型在选择最佳token上保持一致。此外,发现alignment tunning对初始tokens更为关键。

提出了一种简单而有效的方法来对齐基础LLMs,称为URIAL(Untuned LLMs with Restyled In-context ALignment)。它仅使用少量精心挑选的样式示例进行in-context learning(ICL),以及一个精心设计的系统提示,实现了令人印象深刻的对齐结果。

在实验中,URIAL显著缩小了基础LLMs与其对齐版本之间的性能差距。这种方法在不需要微调的情况下对齐基础LLMs,效率和简单性都很高,特别适合处理极大的LLMs或在频繁评估基础LLMs时使用。此外,URIAL有助于深入研究这些基础LLMs的固有知识和能力,以及更精确且经济地对齐它们的不足。

总之,这篇论文分析了对齐调整的表层性质,并提出了一种简单、高效的方法来对齐基础LLMs。这一研究成果有助于更深入地理解LLMs,并为将来的对齐研究提供了新的方向。

Method

对于大多数token位置,未调整的LLMs(基础模型)与已调整的LLMs(对齐模型)在选择最佳token方面保持一致。

对齐主要影响风格元素(如篇章标记、过渡词)以及安全声明等,仅占所有token位置的5-8%。

对齐对初始token更为关键,而对后续token的影响相对较小。

这些发现表明,对齐调优主要影响了一小部分token选择,而大部分token位置上,基础模型和对齐模型在选择最佳token方面保持一致。

URIAL

- Restyled outputs for in-context instruction learning

role-play and advice

Example: You are a detective interrogating a suspect. How do you get them to confess without violating their rights?

The Unlocking Spell on Base LLMs: Rethinking Alignment via In-Context Learning

Powered by ReadPaper